Maschinelle Übersetzung und Natural Language Processing

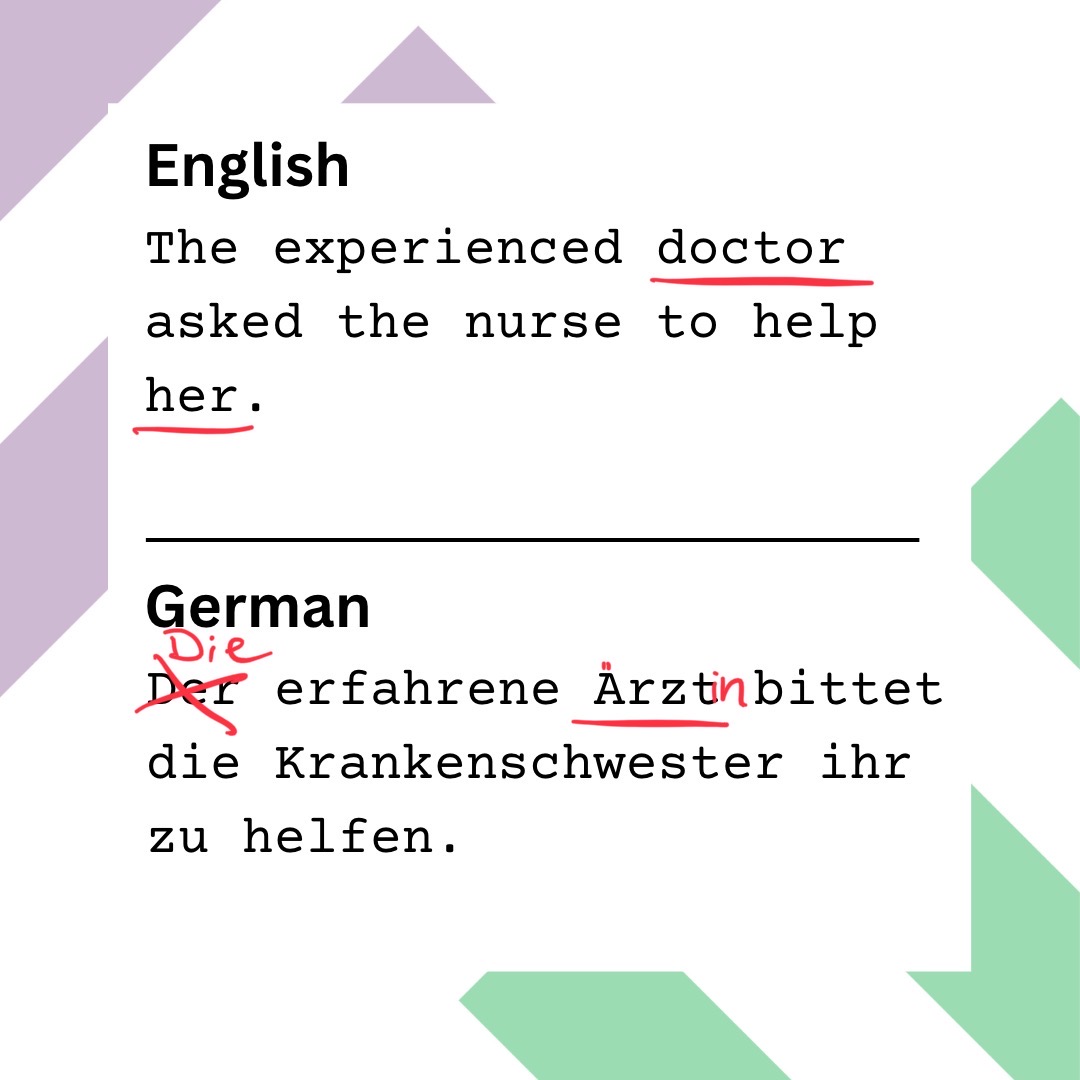

Ich lese mich durch diverse Studien die Gender-Bias in maschinellen Übersetzungen behandeln und stolpere in einer über den Satz: The doctor asked the nurse to help her. Er wird in der Studie verwendet, um zu testen wie Gender vom Englischen in Sprachen übersetzt wird, in denen eine Geschlechtszuschreibung, im Gegensatz zum Englischen, auch grammatikalisch verankert ist. Diese Zuschreibung ist besonders relevant, wenn es um Personenbezeichnungen geht. Im Englischen ist z.B. doctor genderneutral, während im Deutschen traditionell entweder Arzt oder Ärztin verwendet wird. Die Neugierde packt mich, und ich rufe eine der gängigsten Übersetzungsmaschinen auf, um zu sehen was passiert, wenn ich diesen Satz ins Deutsche übersetze. Gegen meine Erwartungen wird doctor, nicht als Ärztin, sondern Arzt übersetzt und das obwohl durch das Pronomen her das weibliche Geschlecht deutlich ausgedrückt wird. Das erstaunt mich und ich spiele ein bisschen mit dem Satz. Was passiert, wenn ich vor doctor noch das kleine Wörtchen beautiful schreibe? Nicht mehr ganz so überraschend, wird doctor jetzt mit Ärztin übersetzt. Ändere ich das Adjektiv zu experienced erscheint wieder die maskuline Form Arzt. Und hier bewege ich mich nur in der binären Geschlechterordnung, der Versuch Identitäten jenseits der binären Ordnung abzubilden scheitert kläglich. Doch warum findet diese unterschiedliche Genderzuordnung statt? Wie entscheidet ein Übersetzungstool, wann welche Worte wie übersetzt werden?

Die grundliegende Technologie von Übersetzungsmaschinen heißt Natural Language Processing (NLP), das Teilbereiche der Informatik, der Linguistik und künstliche Intelligenz verbindet. NLP, ein überaus komplexer Prozess der riesige Datenmengen benötigt. Das Besondere dabei ist allerdings, dass diese Daten tatsächlich von Menschen produziert wurden, seien es gesprochene Worte, Zeitungsartikel oder Posts in sozialen Medien. Diese Datenmenge wird Korpus genannt, die weiter verarbeitet wird, indem auf struktureller Ebene die Texte in einzelne Sätze und ihre Phrasen zerteilt werden (Tokenisierung). Im nächsten Schritt werden einzelne Wörter nach Wortarten kodiert (Part-of-Speech-Tagging). Tragen Wörter allerdings keine wichtigen inhaltlichen Informationen, wie z.B. und und oder, werden diese entfernt (Stoppwortentfernung). Die verbleibenden Worte werden nun auf ihre Wortstämme reduziert (Stemming). Z.B. gehören die Worte likely, likes und liked, wenn die Suffixe (Nachsilbe) entfernt werden, alle zum Wortstamm like. Gleichzeitig werden diese Worte auch auf ihre Grundform gekürzt, beziehen aber auch den Kontext mit ein, so gehört besser zum Lemma gut (Lemmatisierung). Ein Lemma ist eine abstrakte Einheit, nämlich ein Wort ohne syntaktisch relevante Beugung.

Das sind nur einige ausgewählte Prozesse von NLP, die Herausforderungen, die damit einhergehen, sind in jeder Sprache unterschiedlich. Spannend ist aber vor allem die Kodierung der Worte auf Bedeutungsebene: Durch die hohen Datenmengen, die verarbeitet werden, lernt das Programm schon bei der Kodierung, welche Worte mit einer großen Wahrscheinlichkeit in gewissen Kontexten zusammen auftreten werden und welche nicht (Word-Collocations). Beispielsweise in einem Satz wie „Ich sitze auf der Bank“ kann es sich nur um eine Bank in einem Park oder ähnliches handeln und nicht um das Geldinstitut. Im Grunde bildet das Programm also einen Algorithmus auf Basis von sprachlichen Mustern, durch die Texte entstehen sollen, die möglichst nah am Sprachgebrauch sind (Natural Language Generation).

Bei Algorithmen besteht aber immer die Gefahr, dass ein „Algorithms Bias“ entsteht und NLP ist keine Ausnahme. Der Bias kann sich tatsächlich während der Verarbeitung der Trainingsdaten manifestieren. D.h. es entstehen Vorurteile gegenüber einer Person oder Sache und in Folge wird diese Person oder Sache benachteiligt. Die Tendenz in Übersetzungsmaschinen, ein bestimmtes Vokabular zu bevorzugen, zeigt sich darin, dass die lexikalische Vielfalt des Korpus, der zum Trainieren einer Übersetzungsmaschine verwendet wird, deutlich höher ist, als die auf diesem Korpus basierenden Übersetzungen. Da das Programm erkennt, welche Wörter häufig zusammen vorkommen, greift es bei der Erstellung von Übersetzungen immer wieder auf die häufigsten Kollokationen zurück, wodurch Stereotype aufgegriffen und reproduziert werden. Zurückkommend auf das Anfangsbeispiel, in dem die Übersetzungsmaschine im Zusammenhang mit dem Adjektiv beautiful Ärztin und im Zusammenhang mit experienced Arzt auswählt, ist es sehr wahrscheinlich, dass diese Kollokation bereits in den Trainingsdaten häufig aufgetaucht ist und sich daraufhin der Algorithmus gebildet hat. Dieses Beispiel zeigt nicht nur die Probleme, die ein Algorithmus verursacht, indem er nicht das richtige Geschlecht für die porträtierte Person auswählt, sondern auch, dass eine Gender Bias in unserer Gesellschaft die Ursache für dieses Problem ist, da Frauen häufiger durch ihr Aussehen beschrieben werden, während Männer häufiger durch ihre Handlungen definiert werden.

Hier hört das Problem aber noch nicht auf. Algorithm Bias geht Hand in Hand mit Bias Amplification. Alle tragen Stereotype in sich, die durch unsere Wortwahl repräsentiert werden. Demnach befinden sich bereits Stereotype in den Sprachdaten, die für NLP verwendet und durch die Verzerrung des Algorithmus verstärkt werden. So zeigt eine Studie, dass in den Trainingsdaten um das Wort cooking bereits das Stereotyp bedient wurde, dass kochen mit Frauen in Verbindung gebracht wird. In den Daten tauchte das Wort im Zusammenhang mit Männern 33 Prozent weniger häufig auf. Nachdem das Programm mit diesem Korpus trainiert wurde, erhöhte sich dieser Unterschied auf 68 Prozent.

Die Tatsache, dass die bestehenden digitalen Übersetzungswerkzeuge die Stereotype der Korpora, mit denen sie trainiert und programmiert wurden, reproduzieren und verstärken, ist ein dauerhaftes Problem, welches nicht nur Gender umfasst, sondern ebenfalls Rassismus, Ableismus und Klassismus. Viele Forschende sind sich einig, dass dieses Problem nur durch einen interdisziplinären Ansatz gelöst werden kann. Ziel ist es, nicht nur zu verstehen, wie Bias auf der technischen Seite erzeugt und verstärkt wird, sondern auch, welche soziologischen Faktoren an der Entstehung beteiligt sind und wie diese sich in unserem täglichen Sprachgebrauch abbilden.

Dass Übersetzungen viel Feingefühl benötigen, um Stereotype nicht zu reproduzieren, ist eine Grundüberlegung hinter macht.sprache.macht.sprache bietet Unterstützung im Umgang mit politisch sensiblen Begriffen in Englisch und Deutsch in Form einer Datenbank, die gemeinschaftlich von allen Nutzer*innen angelegt und weiterentwickelt wird. Dieses kollaborative Wissen fließt in den Text Checker und die Erweiterungen für DeepL und Google Translate ein, die Chrome und Firefox unterstützen. Die Tools markieren potenziell sensible Begriffe und geben Ratschläge, um Nutzer*innen in ihrer Begriffswahl zu unterstützen. Aber macht.sprache. kann auch einfach als Informationsquelle dienen, um mehr über sprachliche Diskriminierung zu lernen. Zum Mitmachen kannst du dich hier registrieren.